L’idea di Evan Thompson in Mind in Life: Biology, Phenomenology, and the Sciences of Mind. Harvard University Press, 2010, è che l’explanatory gap (con cui egli identifica lo hard problem di Chalmers), cioè il problema di capire perché siamo coscienti, cioè perché gli stessi meccanismi cerebrali correlati alla nostra esperienza soggettiva non potrebbero funzionare altrettanto bene senza che noi fossimo consci, possa venire “ridotto” se non risolto sulla base dell’analogia tra il modo di funzionare autopoietico del vivente e quello della coscienza.

(In un certo senso, su tutt’altre basi – evoluzionistiche – , sembra anche l’intuizione che presiede al volume di Simona Ginsburg ed Eva Jablonka. The Evolution of the Sensitive Soul. Learning and the Origins of Consciousness, MIT Press, Massachusetts, 2019, in cui i marcatori dell’origine della vita sono visti come “analoghi” ai marcatori dell’origine della coscienza).

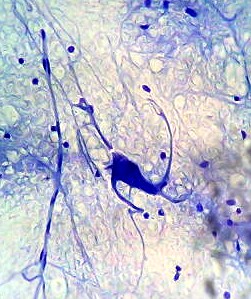

Per comprendere in che senso Thompson intenda quest’analogia (tra forma della vita e forma della coscienza) bisogna ricordare il significato di “autopoiesi” (definito originariamente nel testo di Francisco Varela e Humberto Maturana Autopoiesis: the organization of the living (1972) ampliato e integrato con uno scritto precedente sulla cognizione in Autopoiesis and Cognition, Dordrecht, Netherlands, Reidel, 1980): un essere vivente sarebbe fondamentalmente una macchina in grado di rigenerare continuamente se stessa. In particolare esso sarebbe contraddistinto dal fatto di auto-organizzarsi, cioè di produrre i componenti che, interagendo tra loro, producono se stessi e l’intero di cui sono parte.

Si tratta di un interessante approccio antiriduzionistico (perché nel vivente opererebbe una downward causation dall’intero alle parti, tale per cui l’intero è “maggiore della somma delle parti”, in senso olistico), ma dichiaratamente deterministico e meccanicistico (non si ritiene che operino “cause finali”, “campi morfogenetici”, “forze occulte”, “anime” o comunque entità non materiali come nel vitalismo).

L’aspetto che mi aveva interessato era il fatto che anche il “confine” dell’organismo risulta determinato dall’organismo stesso e, a sua volta, determina lo sviluppo del medesimo, come nel caso paradigmatico della cellula. Secondo gli autori la “macchina autopoietica”, a differenza di un computer, non riceve in input informazioni, le elabora e restituisce in output informazioni, ma tende solo a riprodurre se stessa: gli “input” sono soltanto “perturbazioni”, non diversamente da quelle che potrebbero venire dall’interno della macchina, a cui la macchina vivente reagisce rimaneggiando se stessa per mantenere la propria auto-organizzazione. Questo processo sarebbe anche una forma di cognizione (noi diremmo apprendimento o adattamento). Inoltre, non solo i confini sono stabiliti dallo stesso vivente mentre vive, ma in un certo senso anche l’ambiente (la nicchia ecologica) nel suo complesso è co-determinato dall’organismo. Ciascuno ha l’universo che si merita, potremmo dire (noi percepiamo certe frequenze luminose e lo spazio in un certo modo, un’ameba vive in un ambiente del tutto diverso; inoltre ogni organismo, insieme con gli altri conspecifici e non, non è solo condizionato dall’ambiente ma contribuisce a definirlo).

Come si chiarisce meglio nel libro scritto da Thompson con Francisco Varela ed Eleanor Rosch, The Embodied Mind: Cognitive Science and Human Experience, MIT Press, 1991 (in cui sparisce misteriosamente il concetto di autopoiesi, a favore di una semplice, ma sinonimica “self-organization” – l’autopoiesi riappare comunque in Mind in Life) l’interazione tra organismo e ambiente ha carattere “enactive“. L’azione è influenzata dalla percezione e questa dall’azione in un circolo di feedback continui in cui non passerebbero informazioni in senso informatico, ma si svolgerebbe un processo che è cognitivo e “adattativo” insieme (e in cui anche l’ambiente viene in un certo senso configurato). Anche se con linguaggio diverso non si tratta di un approccio molto diverso, secondo me, di quelli di Seth e Hoffman: la “mente” funzionerebbe proiettando sul “mondo” le proprie ipotesi o aspettative “bayesiane” e correggerebbe via via il tiro in base al feedback che riceve (secondo me il paradigma è il modo in cui un bambino piccolo impara a stringere gli oggetti per prova e errore senza che nessun “gene” abbia predeterminato l’esatta modalità operativa per avere successo).

Ciò che mi aveva colpito è quest’idea di coevoluzione o codeterminazione tra organismo, dai confini sfumati, e universo. Ci vedevo una forma embrionale di “uno-tutto”. È come se l’organismo fosse l’universo stesso che assume una determinata configurazione, senza confini netti tra la parte e il tutto.

A questo punto, però, sempre dal mio punto di vista, diventava urgente capire la differenza tra “vita” (così o altrimenti concepita) e “coscienza”. Mind in Life sembrava, al riguardo, molto promettente.

Thompson, che è filosofo, sviluppa innanzitutto un’interessante discussione sui limiti epistemologici delle scienze cognitive, mettendo in luce la funzione trascendentale (termine mio, ma per chiarire) della coscienza (e, quindi, il “bisogno” epistemologico di filosofia e specialmente della fenomenologia di Husserl, Heidegger, Merleau-Ponty ecc.). Lo scienziato cognitivo spesso non mette a tema il fatto che, quando tratta della coscienza, mette in gioco la sua stessa coscienza, senza averne accuratamente analizzato i tratti fenomenologici (si può arrivare così, noto io, a dimostrare che la coscienza, in quanto si sarebbe evoluta solo per favorire la fitness, non è affatto attendibile cognitivamente, senza accorgersi che, in questo modo, si taglia il ramo su cui lo stesso neuroscienziato, in quanto il suo sapere deriva dalla sua coscienza, è seduto!). La coscienza non è solo un oggetto di indagine, ma anche lo strumento mediante cui l’indagine è condotta. Essa (la coscienza soggettiva del ricercatore) opera occultamente come termine di paragone anche in quegli approcci che si dichiarano “oggettivistici” e cercano di limitarsi ai “dati” ricavati p.e. dalla scansione del cervello e dai reports (che sono a loro volta interpretazioni soggettive!) dei soggetti su cui si effettuano gli esperimenti.

Purtroppo, quando Thompson passa a trattare della coscienza, introducendo la sua “neurofenomenologia” (ispirata a Varela, nel frattempo deceduto per complicanze legate a problemi al fegato), cioè un forma di fenomenologia naturalizzata, in cui l’autoanalisi fenomenologica illumina i dati sperimentali e viceversa, fa interessantissime osservazioni ecc., ma, secondo me, non riesce in alcun modo a ridurre l’explanatory gap.

La vaga analogia tra il funzionamento “olistico” della coscienza (che, a sua volta, come anche il cervello, non dovrebbe essere vista come un elaboratore di informazioni, ma come un sistema che si auto-organizza omeostaticamente ecc.) e quella della cellula non ci aiuta a capire come si passi da questa a quella.

Thompson si limita a scagliarsi contro il dualismo cartesiano, operante anche in Chalmers, nei “rappresentazionalisti” come Jerry Fodor, in Jaegwon Kim ecc. Se si “riduce” la natura, anche biologica, in senso deterministico-meccanicistico-fisicalistico ecc. non si riuscirà mai a derivarne la coscienza. Se, invece, si intendono i fenomeni biologici come irriducibili a quelli fisici, cioè come dotati di una capacità di auto-organizzazione (è interessante che Thompson riconosca a Kant il merito, nella Critica del Giudizio, di avere introdotto per la prima volta la nozione di “causalità circolare” per interpretare il vivente e, nel suo ultimo libro, andando ben oltre Maturana e Varela, “sdogana” anche la nozione di “causalità finale” anche se sganciata da ogni idea di “progetto” trascendente, come “purposiveness” intrinseca all’organizzazione autopoietica), il gap con i fenomeni soggettivi, caratteristicamente “intenzionali”, della coscienza si ridurrebbe.

Questa strategia sembra promettente, ma, secondo me, è assai problematica. Proprio l’analogia tra i due tipi di fenomeni (vita e coscienza) mantiene in essere il quesito: se la vita è così “potente” come processo capace di auto-organizzazione anche quando è inconscia, perché a un certo punto si è evoluta la coscienza?

Tra l’altro è curioso che Thompson & co. “attaccano” anche la teoria dell’evoluzione per selezione naturale. Però, per così dire, anche se certi loro argomenti sono convincenti, la attaccano da “sinistra” (mentre chi scrive, più sensibile alle sirene dell’intelligent design o, meglio, di una certa lettura del principio antropico, tende ad attaccarla da “destra”). Cioè, l’idea è che gli organismi evolvano spontaneamente (si rasenta anche il lamarckismo, esaltando la possibilità della trasmissione epigenetica o “culturale” dei caratteri acquisiti) e che la selezione naturale si limiti a eliminare i casi disperati. Non si registrerebbe una tendenza a ottimizzare la fitness, ma solo a conservare in essere organismi minimamente o sufficientemente adattati. La tesi di fondo è che l’autopoiesi e non l’evoluzione caratterizzerebbe la vita. L’evoluzione sarebbe un fenomeno “storico” non strutturale (è all’incirca la tesi di Piantelli e Fodor nel libro Gli errori di Darwin). La selezione, per operare, presuppone la vita, non la crea.

A pensarci, questo genere di critiche, secondo me, non portano lontano. Invece di spiegare la vita e l’intelligenza (o la coscienza) allontano la spiegazione, conferendo un ruolo eccessivo o al caso o a ipotetiche leggi “autopoietiche” che, però, se le si dovesse veramente prendere sul serio, richiederebbero di reintrodurre l’élan vital, cause finali e formali (campi morfici) o, infine, di nuovo, un intelligent design.

Poi a me sembra un sofisma affermare la selezione presuppone la vita. Certo, in Darwin questo è letteralmente vero. Ma che cosa vieta di supporre che la selezione operi sulla chimica, cioè sugli ipercicli autocatalitici che, secondo alcuni, pur non essendo ancora pienamente strutture autopoietiche, potrebbero essere i precursori della vita? In qualche modo, se ci si vuole mantenere in un orizzonte materialistico, si dovrà pure spiegare l’origine della prima cellula autopoietica. Se si rinuncia alla selezione, ci si deve affidare per forza al puro caso.

La mia critica “da destra” è basata sul fatto che, anzi, l’evidente ottimizzazione delle funzioni dei viventi non può essere frutto né del caso, né della mera selezione, ma richiede una spiegazione più “forte”, Dio o la necessità che scaturisca la coscienza. La coscienza, nel mio modello, sarebbe sia il fine ultimo dell’evoluzione, sia, circolarmente, la condizione di possibilità “trascendentale” (in quanto introduce il tempo, prima assente) dell’evoluzione medesima.

Ma questo è Giacometti, non Thompson.

E comunque rimane inevaso il problema del passaggio dalla vita alla coscienza. Nella mia prospettiva si tratta di ciò che “demarca” la capacità dell’universo di osservare se stesso. Forse è il fatto di possedere (o rappresentarsi di possedere) un sistema nervoso (trattato da Thompson & co. come un sistema auto-organizzato) con certi tratti, p.e. la neocorteccia? Oppure è il fatto di azzerare completamente l’entropia interna (interessante che Thompson unifichi l’idea di sistema auto-organizzativo chiuso, per caratterizzare il vivente, con quella di struttura dissipativa energeticamente aperta, lontana dallo stato di equilibrio termodinamico, ma capace di “mantenersi” in questa condizione)? Insomma quale mai è il correlato (secondo me con ruolo non causale, ma solo di “trigger”) della coscienza?